Der Begriff Crawlbudget ist immer im Bereich Suchmaschinenoptimierung (SEO) immer wieder zu lesen und zu hören. Google hat sich hierzu in seinem Webmasterblog geäußert und klargestellt, dass es keinen einzelnen Faktor gibt, der mit Crawlbudget einhergehen würde.

Nichtsdestotrotz wird dargelegt, dass zwei Faktoren existieren, die das Crawlverhalten der Googlebots maßgeblich beeinflussen und diese letztendlich doch wieder zu einer Begrenzung des „Crawlbudgets“ führen.

Crawling-Frequenz und Crawling-Bedarf

Würde der Google-Bot in sehr kurzer Zeit umfangreiche Webseiten komplett crawlen, so käme das im weitesten Sinne einer DDOs-Attacke gleich: im schlimmsten Fall wäre die Webseite nur noch eingeschränkt oder gar nicht mehr erreichbar, da zu viele Anfragen gleichzeitig am Server eingehen würden. Aus diesem Grund misst der Bot u.a. die Antwortgeschwindigkeit des Servers und passt daraufhin die Abstände zwischen den jeweiligen Abfragen an.

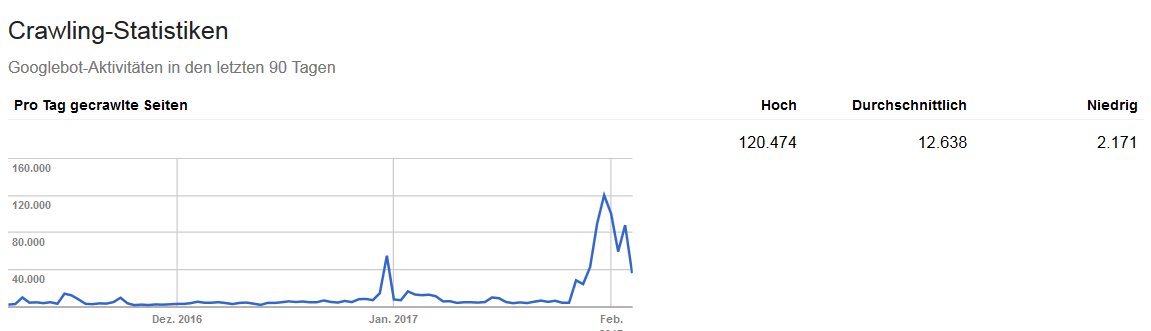

Sollte der Googlebot dennoch massiv danebenliegen, bleibt dem Webseitenbetreiber auch noch die Option, die Crawling-Frequenz in der Google Search-Console anzupassen. In den meisten Fällen ist dies jedoch nicht notwendig.

Daneben versucht Google den Crawling-Bedarf einer Website zu ermitteln und zielt dabei in erster Linie auf aktuelle Inhalte ab. Hierbei spielen die Beliebtheit der einzelnen URLs sowie der Status der URL (veraltete URL oder noch aktuell?) eine entscheidende Rolle.

Wie kann das Crawling erleichtert werden?

Auch wenn Google sagt, dass die Crawling-Möglichkeiten keinen Einfluss auf das Ranking haben, ist es natürlich essenziell – denn ohne Crawling gibt es kein Ranking.

Wichtig ist vor allem, die Webseiten aus technischer Sicht solide aufzustellen. Dies beinhaltet eine ausgereifte Ladegeschwindigkeit und gute Antwortzeiten des Servers. Ergänzend sollten Soft-Errors auf einem möglichst niedrigen Niveau gehalten werden.

Wenig überraschend ist die Aussage, dass sich gehackte Seiten, Spam, Duplicate Content oder eine fehlerhaft umgesetzte facettierte Navigation schlecht auf das Crawling auswirken.

Fazit

Damit Crawlbudget überhaupt ein Thema wird, muss die betroffene Webseite sehr umfangreich sein– also aus mehreren tausend URLs bestehen. Insgesamt wird deutlich, dass wieder mal die Seitengeschwindigkeit und guter, einzigartiger Content die Basis für eine gesunde Entwicklung darstellen.